保护隐私!全球首个神经技术伦理准则来了

这些准则侧重于保护用户免受可能侵犯人权的技术滥用的伤害,包括对自主权和思想自由的侵犯。

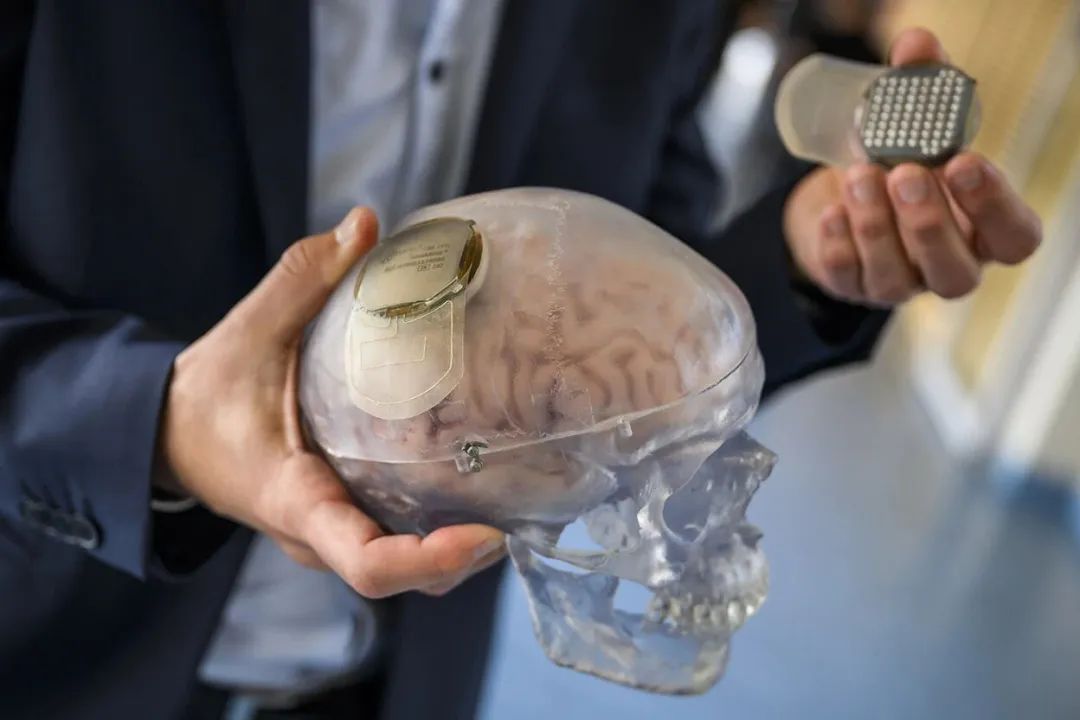

20年来,Ann Johnson因中风一直无法行走和说话,她的平衡能力以及呼吸和吞咽能力也都受到了损害。但2022年,一个脑植入物让Johnson终于又能听到自己的声音了。

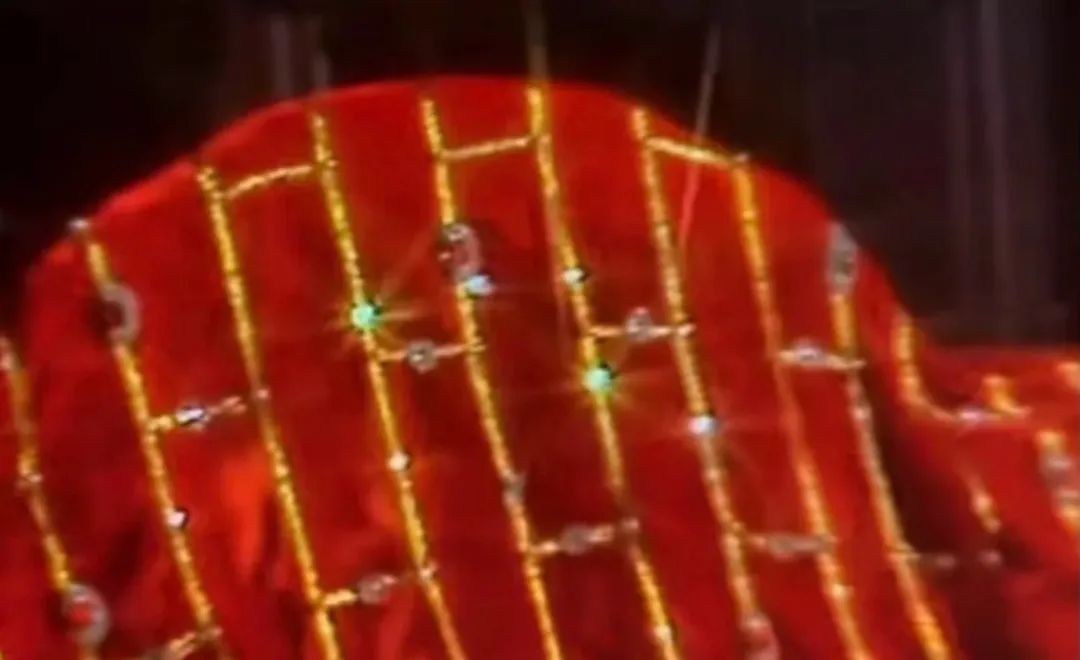

一个装有脑机接口植入物的人类头骨模型。图片来源:JEPA-EFE/Shutterstock

该植入物是过去5年神经技术进入人体试验阶段的一个例子。这类由埃隆·马斯克创办的Neuralink等公司开发的设备,可以改变神经系统的活动,从而影响言语、触觉和运动等功能。近日,联合国教科文组织(UNESCO)在法国巴黎举行了一场会议,与会代表最终确定了一套管理这种神经技术的伦理准则。

这些准则侧重于保护用户免受可能侵犯人权的技术滥用的伤害,包括对自主权和思想自由的侵犯。由科学家、伦理学家和法律专家组成的与会代表最终确定了9项准则,包括建议技术开发者披露神经信息的收集和使用方式,以及确保产品对人们心理状态的长期安全性。

“这份文件阐明了如何保护人权,特别是与神经系统相关的人权。”智利圣地亚哥大学的神经科学家Pedro Maldonado说。他是起草这份准则的24位专家之一。这些准则不具备法律约束力,但国家和组织可以用它们制定自己的政策。今年11月,UNESCO的194个成员国将投票决定是否采用这些标准。

在美国和欧盟等地区,针对植入式脑机设备已有立法。但非医疗消费级设备,如可穿戴设备,受到的监管则较少。参与起草准则的美国麻省理工学院的神经技术学家Nataliya Kosmyna表示,这些设备因其快速规模化的潜力而引发了伦理担忧。

其中对非侵入性设备的一个担忧是,眼球运动和语调等信息可能被用来推断神经数据,包括某人的心理状态或大脑活动。专家们担心,这种行为可能在用户不知情的情况下发生,例如在他们睡着的时候。

德国慕尼黑工业大学的伦理学家Marcello Ienca表示,商业神经设备已经带来了数据和安全风险,特别是对“心理隐私”而言。“关于大脑和心智的数据应该受到更高程度的保护,以防范未经授权的心智信息泄露。”他说。

保护心理隐私的一种方式是征得用户同意。UNESCO建议,这些同意需要是“事先、自由和知情的”,并且应包含在任何时候放弃使用这项技术的选择。

未参会的美国乔治·华盛顿大学技术伦理学家Vikram Bhargava则认为,知情同意并非万无一失。“这些神经数据不仅提供了关于你的信息,还可能提供关于其他具有相似神经特征的人的信息。”

其他人则不同意这一观点。“人们思维方式的相似性更多与他们的居住地、生活方式有关,而不是大脑的运行方式。”Maldonado 说。

尽管如此,“拥有一个各国承诺遵守的全球标准是非常有利的”。美国杜克大学的法律学者兼伦理学家Nita Farahany说。

但美国在人工智能等领域出现的监管放松态势表明,法律工具可能不足以解决所有问题。Farahany说,相反,各国应鼓励开发者设计更多能为用户提供保护的功能。