“幻觉”谜团:为何AI会编造虚假信息?

你是否遇到过这样的情况? 让AI写一篇关于“恐龙灭绝”的科普文章, 它突然提到“霸王龙曾与原始人类共同生活”; 请它推荐旅游攻略, 却发现它描述的景点在地图上根本不存在。 这些令人啼笑皆非的错误,暴露了生成式AI的一个致命缺陷——自动生成错误信息, 即“幻觉”(Hallucination)。

你是否遇到过这样的情况?

让AI写一篇关于“恐龙灭绝”的科普文章,

它突然提到“霸王龙曾与原始人类共同生活”;

请它推荐旅游攻略,

却发现它描述的景点在地图上根本不存在。

这些令人啼笑皆非的错误,暴露了生成式AI的一个致命缺陷——自动生成错误信息,

即“幻觉”(Hallucination)。

这种现象并非AI在故意欺骗人类,

而是源于它的“思维模式”与人类本质不同。

01

本质区别:

AI的“脑回路”与人不同

1.数据处理方式

AI:基于数字和概率处理信息

人类:结合感官体验与知识概念建立认知

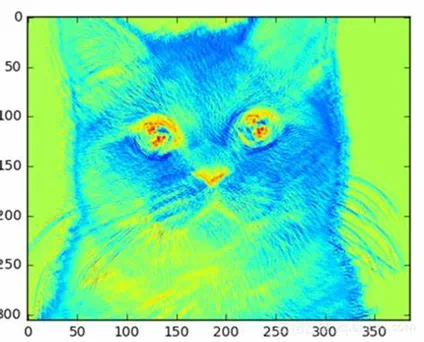

当人类看到猫时,我们会自动联想到猫咪"柔软的毛发""独立的性格"等具象体验,甚至触发情感记忆,例如回想起曾经与养过的宠物在一起的美好瞬间。但人工智能只能记住一张有关于猫咪的照片的像素点是如何分布的,有哪些颜色特点。

2. 逻辑推理的局限性

AI:依赖规则或关联度实现推断

人类:运用常识和因果进行推理

当医疗AI诊断肺炎时,由于过度依赖之前学习到的图像经验,可能误将X光片上的金属纽扣阴影视为病灶;而医生则可以结合患者咳嗽症状、体温数据,排除衣物干扰因素,甚至考虑患者精神外貌来综合判断病情。

3. 情感与价值观影响

AI:判断过程无主观情感体验

人类:决策受情绪和道德观影响

当人工智能为你总结书籍的剧情和人物特点时,其本质是它对文字的学习和概括,而不能像每一位读者一样,沉浸式体验角色的喜怒哀乐。

以上种种差异导致AI在图像识别、大数据处理方面远超人类,但在情境理解、思维迁移、价值判断等层面仍存在显著局限,二者的互补性正是人机协同发展的基础。

02

错误泡沫:

从先天缺陷到恶性循环

1.核心机制:AI的先天缺陷

AI就像是一个沉迷文字接龙游戏的超级玩家,它不断预测"最可能出现的下一块积木",却不知道自己在搭建的是真实世界还是空中楼阁。

人工智能(如大语言模型)通过概率预测文本的下一个词是什么,就像大块的积木上面总是再搭一个小些的积木,而非真正理解语义或验证事实。这种机制导致模型在遇到知识盲区时,倾向于用概率高的关联词填补空白,而非主动承认“我不知道”。

2.成长限制:错误和老旧的“课本”

(1)训练数据覆盖不全与错误污染

AI的“知识”完全依赖于你给与它的“课本”,当前的文本数据经常会包含错误信息(如过时的科学结论或虚构案例),且无法覆盖所有领域,导致数据污染问题尤其突出。

如果老师告诉小朋友“1+1=3”时,再聪明的大脑也会进入宕机状态。

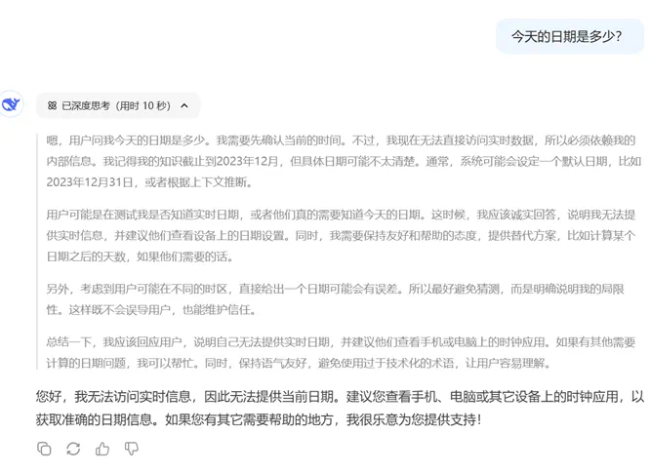

(2)时效性与更新滞后

模型无法实时获取最新信息,将会导致生成内容与当前现实脱节。当我们使用AI大模型,倘若不打开联网模式,就很有可能无法获取最新的实时消息,作者在deepseek中询问当前日期,得到的结果如图:

同理,对于技术更新速度极快的领域,迟滞的数据将不可避免带来大模型表现的失灵。

3.人工智能的强迫症:我要完美应答

与模棱两可的回答相比,模型总是默认追求生成“流畅自然”的文本,而非主动标注不确定性,因为这在代码的底层就刻上了“满分回答”的DNA标签。

当被问及"2029年房价走势",它宁可编造科幻小说般的预测,也不愿承认自己不知道,仿佛一位强迫症画家,宁可画上虚构的第六根手指,也不愿留白。

4.谣言传播:蝴蝶效应的恶性循环

模型生成的错误内容若被再次作为学习的“课本”输入,可能形成“幻觉-学习-再幻觉”的恶性循环。例如,虚构的学术论文被其他AI引用,导致虚假知识扩散。

在自动驾驶等场景中,传感器数据误差经模型多层处理后会被放大,一个误判的塑料袋影像,经过多层"传话游戏",就可能被放大成"前方有恐龙"的致命判断,最终触发立刻停车的危险决策。

理解AI幻觉就像看魔术揭秘——当你知道它依赖统计魔术而非真实魔法,就会明白那些惊艳表演背后的机关暗道。这提醒我们既要惊叹于AI的文字魔术,也要时刻检查它藏在帽子里的兔子是不是塑料道具。

03

三个关键原则:

如何与“爱幻想的AI”安全共处?

人工智能像拥有无限想象力的童话作家,既能创作诗歌又能解答疑问,但偶尔会把"幻想"当成真实。作为新手用户,只需掌握三个关键原则就能与它安全共处:

1.当个"侦探"验证信息

AI的回答可能混杂虚构内容,尤其是面对开放性问题时。不妨追问"这个结论有依据吗?"或"数据来源是什么?",就像检查商品真伪时查看防伪标识。对重要信息,建议用多个可靠渠道交叉验证,比如用搜索引擎核对历史年份,查阅官方数据库验证专业数据。

2.做"导演"明确指令

避免问模糊的"如何成为科学家?",试着换成"科学家需要哪些核心素质?"。像导演给演员说戏般,用"分步骤解释""举例说明"等具体指令,能帮助AI聚焦现实逻辑。必要时可补充"基于真实案例""引用权威文献"等限定词。

3.保持"人间清醒"

记住AI是拓展认知的工具而非终极答案。面对职业规划、健康建议等人生大事,它的回答只能作为参考灵感。就像使用导航软件时,最终方向盘仍要掌握在自己手中——人类的常识、情感和价值观,才是判断AI建议是否靠谱的终极标尺。